Termin “deep fake” znany jest od kilku lat. To realistycznie wyglądające, ale nieprawdziwe, generowane lub edytowane przez sztuczną inteligencję (AI) materiały wideo, audio lub zdjęcia. W październiku 2025 kilka nowych narzędzi do generowania wideo przesunęło granice tego, jak łatwo takie materiały tworzyć i rozpowszechniać. Aplikacje takie jak Sora czy Meta AI sprawiają, że tworzenie ich jest błyskawiczne i banalnie proste. Jeszcze większą zmianę może przynieść umieszczenie ich bezpośrednio w mediach społecznościowych, gdzie już teraz powszechnie dzieci spędzają mnóstwo czasu. Jakie zatem wyzwania dla edukacji i osób pracujących z młodzieżą mogą nieść media syntetyczne? I jak próbować sobie z nimi radzić?

Czym jest Sora?

Sora to nowa aplikacja w stylu TikToka, która prezentuje strumień filmów wygenerowanych wyłącznie przez sztuczną inteligencję. Po jej zainstalowaniu każdy użytkownik lub użytkowniczka, skanuje swoją twarz i nagrywa głos, aby stworzyć hiperrealistyczny awatar, który naśladuje wygląd i głos. Taki awatar można wstawiać do własnych filmików lub łączyć ze scenkami od innych osób (w zależności od udzielonych przez nich uprawnień). Filmiki tworzy się za pomocą krótkich instrukcji tekstowych i mogą udawać w zasadzie dowolne sceny, które znamy z prawdziwych filmów dostępnych w sieci, na których model był uczony.

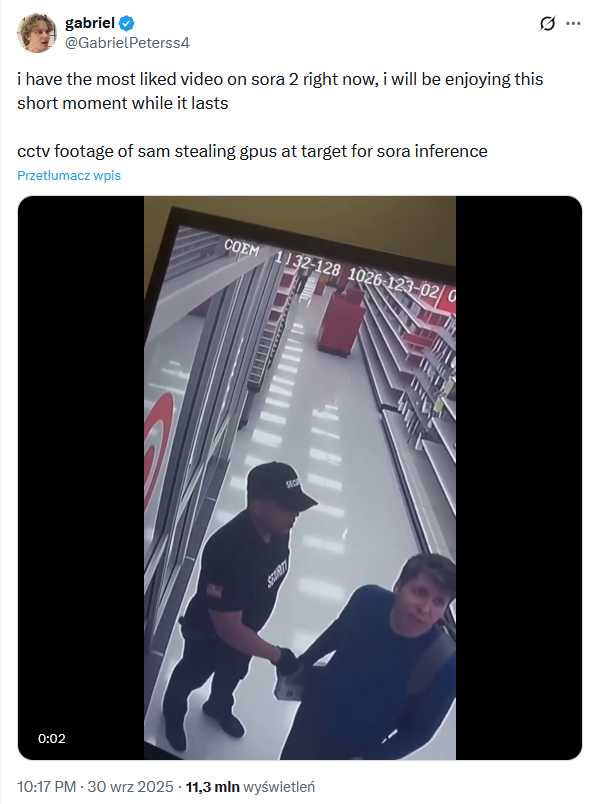

W pierwszych dniach zarówno w Sora, jak i skopiowane na różne media społecznościowe, pojawiły się wideo przypominające relacje z fikcyjnych przestępstw i aresztowań (jak na przykładzie poniżej z CEO OpenAI, Samem Altmanem), znane zmarłe postacie w absurdalnych i nieprawdziwych sytuacjach, scenki typu: koń niesie na grzbiecie drugiego konia, czy - początkowo - sceny z kreskówek. Zanim oburzymy się na to, co mogą stworzyć z tego dzieci i nastolatki, przypomnijmy, że póki co do aplikacji mają dostęp tylko dorośli użytkownicy z zaproszeniami.

Aplikacja dostępna jest na razie tylko w USA i Kanadzie i wymaga zaproszenia od innego użytkownika lub użytkowniczki, co tylko potęguje jej wirtualną popularność. Nie pierwszy raz, taka atmosfera „niedostępności” służy do spopularyzowania jakiejś aplikacji - 20 lat temu tak zaczynał Gmail, a potem Facebook. Błyskawiczna popularność Sory wynika również z tego, jak łatwe jest tworzenie w niej realistycznych treści oraz dostępność prawdziwych wizerunków osób. Możliwość zrobienia zabawnej (lub niecenzuralnej) sceny z nami lub znajomymi to niesamowicie wciągająca funkcja.

Sora to jednak więcej niż aplikacja. To model sztucznej inteligencji, który może być wykorzystany przez różne inne narzędzia i aplikacje. Tak jak modele GPT można spotkać w różnych chatbotach (nie tylko w ChatGPT), tak samo możliwości Sory dostępne są już dla użytkowników (w tym dzieci) również w Polsce w aplikacjach do tworzenia wideo. Aplikacji kopiujących treści z amerykańskiej Sory lub udostępniających takie same banalnie proste możliwości generowania filmików z prawdziwymi osobami, możemy spodziewać się tylko więcej. Warto pamiętać, że Sora to nie jedyne narzędzie tego rodzaju. Meta AI, Veo od Google.

Z perspektywy osoby pracującej z dziećmi i młodzieżą warto zwracać bardziej uwagę na nowe możliwości i wynikające z nich zagrożenia niż na same aplikacje. Możliwość generowania realistycznych wideo już z nami zostanie, nawet jeśli zmienią się aplikacje.

Konsekwencje i zagrożenia

Prosta zabawa z cudzym wizerunkiem, który możemy umieścić w realistycznie wyglądającej scenie, to zachęta do nadużyć, przed którą mnóstwo osób, młodych i dorosłych, się nie powstrzyma. Choć twórcy aplikacji dodali w pierwszych dniach kilka ograniczeń i możliwość ustawienia, czy i komu pozwalamy remiksować nasz wizerunek, to niestety warto się liczyć z tym, że możliwe jest ich obchodzenie.

Podobnie jak w przypadku dotychczasowych narzędzi do łatwego tworzenia i modyfikowania treści z wizerunkami prawdziwych osób typu deepfake, najbardziej zagrożone mogą być dziewczyny, kobiety i potencjalne ofiary nękania (bullyingu). Choć w aplikacji dostępne są możliwości ograniczenia remiksowania czyjegoś wizerunku, to łatwo wyobrazić sobie, że będzie to pomijane.

Kolejną konsekwencją, której zapewne można się spodziewać, jest ryzyko naruszenia dóbr osobistych i wizerunków osób znanych. Również zmarłych. Już kilka dni po publikacji Sory, córka Robbiego Williamsa, Zelda, zaapelowała o zaprzestanie wykorzystywania wizerunku zmarłego aktora. Zelda opisała swoją wściekłość nie tylko na ludzi, którzy bez jej zgody przesyłają jej wygenerowane filmiki, ale nawet bardziej na firmy, które tworzą i upowszechniają narzędzia do generowania deepfake’ów z prawdziwymi wizerunkami. Twórcy aplikacji mają możliwości lepszego projektowania swoich rozwiązań i wprowadzania ograniczeń. Błyskawicznie zareagowali na naruszenia praw autorskich do postaci z filmów i kreskówek, w obawie o kosztowne procesy z wytwórniami filmowymi.

Trudno wyobrazić sobie, że tak proste generowanie i rozpowszechnianie materiałów deep fake nie pogłębi problemu, z którym już teraz słabo sobie radzimy: rozpoznawania tego co prawdziwe. Dla młodych osób (ale i dorosłych o niskich kompetencjach cyfrowych), które będą bardziej wyeksponowane na takie treści, wyzwaniem może być nie tylko odróżnianie realnych treści informacji od tych wygenerowanych. Możemy spodziewać się również trudności w budowaniu zaufania wobec przekazów medialnych. Podobnie jak w przypadku wpływu mediów społecznościowych, narzędzie popularyzuje się szybciej niż naukowcy_czynie, w tym psycholodzy i psycholożki, mogą zbadać jego konsekwencje i pomóc nam się uodporniać na nie.

Nowa fala: AI slop i syntetyczne media społecznościowe

Sora to część większego trendu, który można określić jako syntetyczne media społecznościowe lub bardziej dosadnie AI Slop. Są to treści, które można bardzo łatwo wygenerować, większość z nich jest niskiej jakości, a ich ogromna ilość sprawia, że media społecznościowe przestają być o tworzeniu społeczności, a zaczynają być miejscem konsumpcji treści przykuwających uwagę, ale nie niosących wartości. W syntetycznych mediach społecznościowych algorytmy AI nie tylko decydują o tym, co zobaczymy na naszych feedach, ale również tworzą te treści.

Nie jest to wina wyłącznie narzędzi AI. Sposób działania wielu platform opartych o społeczność, który pokazuje już prawie wyłącznie treści serwowane przez algorytm a osób, które obserwujemy, zaadaptowały również inne media. Dodanie do tego możliwości generowania nieprawdziwych scen ze znajomymi lub znanymi osobami prawdopodobnie tylko przyspieszy ten anty-społecznościowy efekt.

Co mogą zrobić nauczyciele?

Umiejętności rozpoznawania wygenerowanych treści to tylko część trudnej układanki kompetencji medialnych. Kiedy wiemy lub spodziewamy się, że większość rzeczy, które widzimy i słyszymy, jest fałszywych, coraz ważniejsze staje się rozumienie kontekstu i celu, w jakim powstają:

- czy jest to próba wprowadzenia nas w błąd?

- próba zmiany naszej opinii na jakiś temat pod przykrywką rozrywki?

- rozbawienie nas, ale takie, które może być krzywdzące wobec kogoś innego?

Popularyzowanie się wygenerowanych treści wideo sprawia, że zasady korzystania z takich narzędzi - zarówno ustalane w szkole, jak i omawiane przez rodziców, są coraz ważniejsze. Potrzebujemy wzmocnienia edukacji na temat wyrażania zgody, poszanowania wizerunku, konsekwencji emocjonalnych tworzenia treści z innymi osobami, konsekwencji prawnych naruszeń prawa.

Kiedy twórcy tych aplikacji i influencerzy w sieci będą promować je jako narzędzia kreatywne, potrzebujemy równocześnie wyjaśniać, że tworzenie treści generowanych przez sztuczną inteligencję, przedstawiających innych bez ich zgody, może naruszać prawo i być krzywdzące. Zarówno dzieciom, jak i dorosłym musimy pomóc zrozumieć, że stwierdzenie „to tylko sztuczna inteligencja” lub „to tylko żart” nie usprawiedliwiają krzywdzenia czy naruszania cudzego wizerunku. Potrzebne jest też rozwijanie krytycznego myślenia - już od najmłodszych lat, które pomoże oceniać, rozumieć kontekst i próbować weryfikować treści i przekazy, na które trafiamy w sieci.

Kluczowe jest świadome decydowanie o naszej obecności w tego rodzaju aplikacjach społecznościowych. Nie tylko z racji na ochronę naszego wizerunku (który niestety może zostać wykorzystany również bez naszej zgody). Używanie ich oznacza również legitymizowanie i popularyzowanie tych aplikacji i potencjalnie ich negatywnych efektów. Jeśli aplikacje takie jak Sora będą stawiać nas w roli bezczynnych świadków tego, co złego się w nich dzieje, narażamy się wszyscy na ryzyko znieczulenia wobec tych efektów. I dlatego tak istotne jest omawiania tych kwestii z dziećmi i młodzieżą już dziś.